Cách đây không lâu, trường hợp của chị V.T.M 26 tuổi, ngụ quận Long Biên, Hà Nội, nhận được tin nhắn mượn tiền từ tài khoản Facebook của người thân bên nước ngoài, mặc dù đã rất cẩn thận gọi video để kiểm tra nhưng nhờ sự giúp sức của công nghệ, nhóm lừa đảo đã thành công qua mặt và chiếm đoạt 75 triệu đồng của V.T.M.

Tờ Wall Street Journal vào năm 2019 từng ghi nhận trường hợp một công ty tại Anh đã mất 243.000 USD vì CEO công ty nhận được cuộc gọi từ người chủ doanh nghiệp yêu cầu chuyển tiền cho đối tác, tuy nhiên đó lại là một giọng nói được làm giả bởi deepfake, thứ công nghệ này có thể giả được chất giọng Đức của người chủ công ty thật đến mức khiến vị CEO kia không một chút nghi ngờ.

Để có thể đối phó và bảo vệ cho bản thân trước những tác động tiêu cực của những kẻ gian lợi dụng deepfake cho mục đích xấu, chúng ta phải có kiến thức và kỹ năng cần thiết. Nhằm giúp độc giả có cái nhìn rõ ràng hơn về vấn đề này, chúng tôi đã có cuộc trò chuyện với chuyên gia bảo mật Ngô Minh Hiếu (Hiếu PC), để tìm hiểu về những nguy cơ tiềm ẩn của deepfake và làm thế nào để tránh việc dữ liệu hình ảnh, giọng nói cá nhân có thể bị deepfake lợi dụng cho mục đích xấu.

Hỏi: Chào anh Hiếu, vấn đề kẻ gian thực hiện hành vi hack Facebook và nhắn tin lừa tiền đã không còn mới, nhưng áp dụng deepfake thì mới xuất hiện gần đây. Với cương vị là một chuyên gia bảo mật, anh Hiếu có lời khuyên nào để mọi người có thể phòng tránh tình trạng này không?

Hiếu PC: Hiện tại công nghệ A.I và đặc biệt là deepfake ngoài được dùng để nhằm phục vụ mục đích tốt, nhưng lại bị một số thành phần sử dụng cho mục đích xấu như lừa đảo, giả mạo, bôi nhọ hay thậm chí là làm ra tin giả dưới dạng video.

Để tránh bị lừa thì tốt nhất là nên tỉnh táo, khi có một ai đó trên mạng xã hội nằm trong danh sách bạn bè của mình mà bỗng nhiên hỏi mượn tiền hay gửi kèm những đường link lạ thì không nên vội, mà hãy bình tĩnh, kiểm chứng và nên xác thực mọi thứ.

Chủ động xác thực bằng cách gọi điện thoại qua số điện thoại trực tiếp hoặc FaceTime ít nhất trên 1 phút. Sau đó giả vờ đặt ra những câu hỏi cá nhân mà chỉ có bạn và người kia mới biết. Vì deepfake sẽ không thể giả được một cuộc trò chuyện thật sự trong thời gian thực mà có tính chính xác cao. Cho đến thời điểm hiện tại, biểu cảm của A.I hay deepfake vẫn không thể bắt chước được như người thật.

Hỏi: Anh có thể lấy ví dụ một vài dấu hiệu nhận biết cụ thể để độc giả dễ hình dung hơn được không?

Hiếu PC: Có lẽ bạn đã từng xem qua một số video hoặc hình ảnh mà nhân vật trong đó có một số dấu hiệu kỳ lạ. Có thể là khuôn mặt của họ thiếu tính cảm xúc và khá "trơ" khi nói, hoặc tư thế của họ trông lúng túng, không tự nhiên, hoặc là hướng đầu và cơ thể của họ trong video không nhất quán với nhau. Những điều này có thể sẽ là điểm rất đáng nghi ngờ và nên dừng lại để suy nghĩ.

Ngoài ra, bạn cũng có thể thấy màu da của nhân vật trong video bất thường, ánh sáng kỳ lạ và bóng đổ không đúng vị trí. Điều này có thể khiến cho video trông rất giả tạo và không tự nhiên. Âm thanh cũng là một vấn đề có thể xảy ra trong video. Âm thanh sẽ không đồng nhất với hình ảnh, có nhiều tiếng ồn bị lạc vào clip hoặc clip không có âm thanh.

Cuối cùng, có thể xảy ra tình huống mà tài khoản chuyển tiền không phải của người đang thực hiện cuộc gọi. Và thường kẻ gian sẽ ngắt giữa chừng, bảo là mất sóng, sóng yếu...

Tóm lại, các yếu tố kỳ lạ như trên là báo hiệu đỏ của deepfake. Bạn nên luôn cảnh giác và tuyệt đối bình tĩnh.

Hỏi: Có thể thấy A.I hay deepfake đang dần trở thành một vấn đề khi nó bị lợi dụng cho các mục đích xấu. Vậy anh có thể chia sẻ làm thế nào để dữ liệu khuôn mặt và giọng nói của mình không bị công nghệ như deepfake lợi dụng cho mục đích xấu?

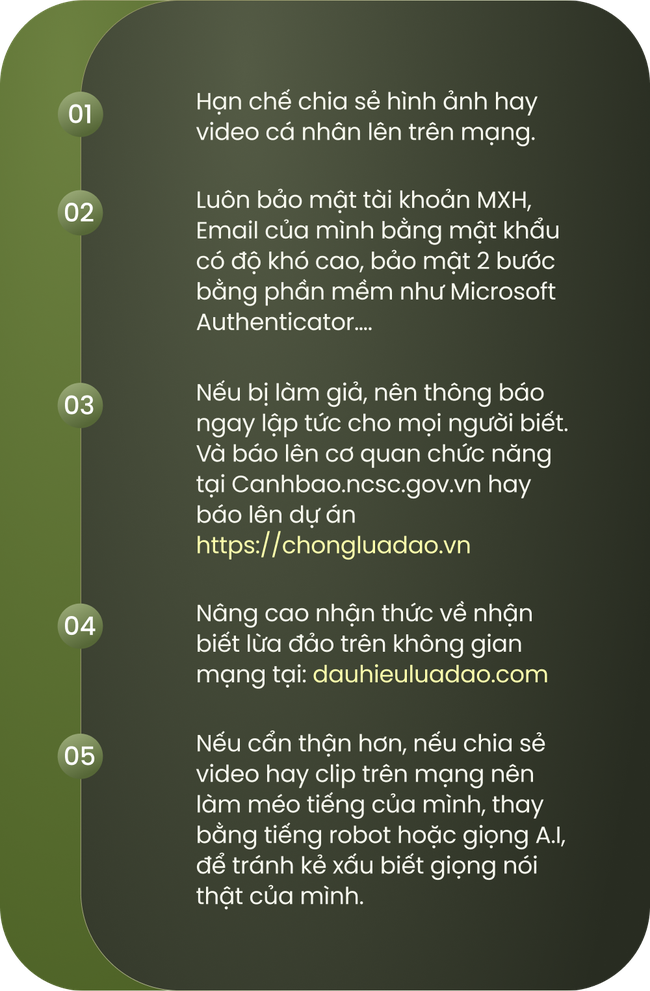

Hiếu PC: Cách tốt nhất để tránh bị làm giả bởi A.I hay công nghệ deepfake thì các bạn nên chú ý các vấn đề sau:

1/ Hạn chế chia sẻ hình ảnh hay video cá nhân lên trên mạng.

2/ Luôn bảo mật tài khoản MXH, Email của mình bằng mật khẩu có độ khó cao, bảo mật 2 bước bằng phần mềm như Microsoft Authenticator….

3/ Nếu bị làm giả, nên thông báo ngay lập tức cho mọi người biết. Và báo lên cơ quan chức năng tại Canhbao.ncsc.gov.vn hay báo lên dự án https://chongluadao.vn.

4/ Nâng cao nhận thức về nhận biết lừa đảo trên không gian mạng tại: dauhieuluadao.com.

5/ Nếu cẩn thận hơn, nếu chia sẻ video hay clip trên mạng nên làm méo tiếng của mình, thay bằng tiếng robot hoặc giọng A.I, để tránh kẻ xấu biết giọng nói thật của mình.

Cảm ơn anh Ngô Minh Hiếu vì những chia sẻ rất có ích này, chúng ta đã được giải đáp một số thắc mắc về deepfake và các biện pháp phòng chống hiệu quả. Tựu chung lại, chuyên gia bảo mật Ngô Minh Hiếu khuyên mọi người nên cẩn trọng hơn khi chia sẻ thông tin, hình ảnh và giọng nói cá nhân trên mạng xã hội. Cuối cùng, việc duy trì một tư duy cảnh giác và sự nhạy bén trong việc nhận diện deepfake là điều rất cần thiết trong thời đại số hóa ngày nay.

.

Tags